Gli emendamenti al Consumer Privacy Act della California ora includono i “dati neurali” nella categoria delle “informazioni personali sensibili” di cui fanno parte i dati biometrici.

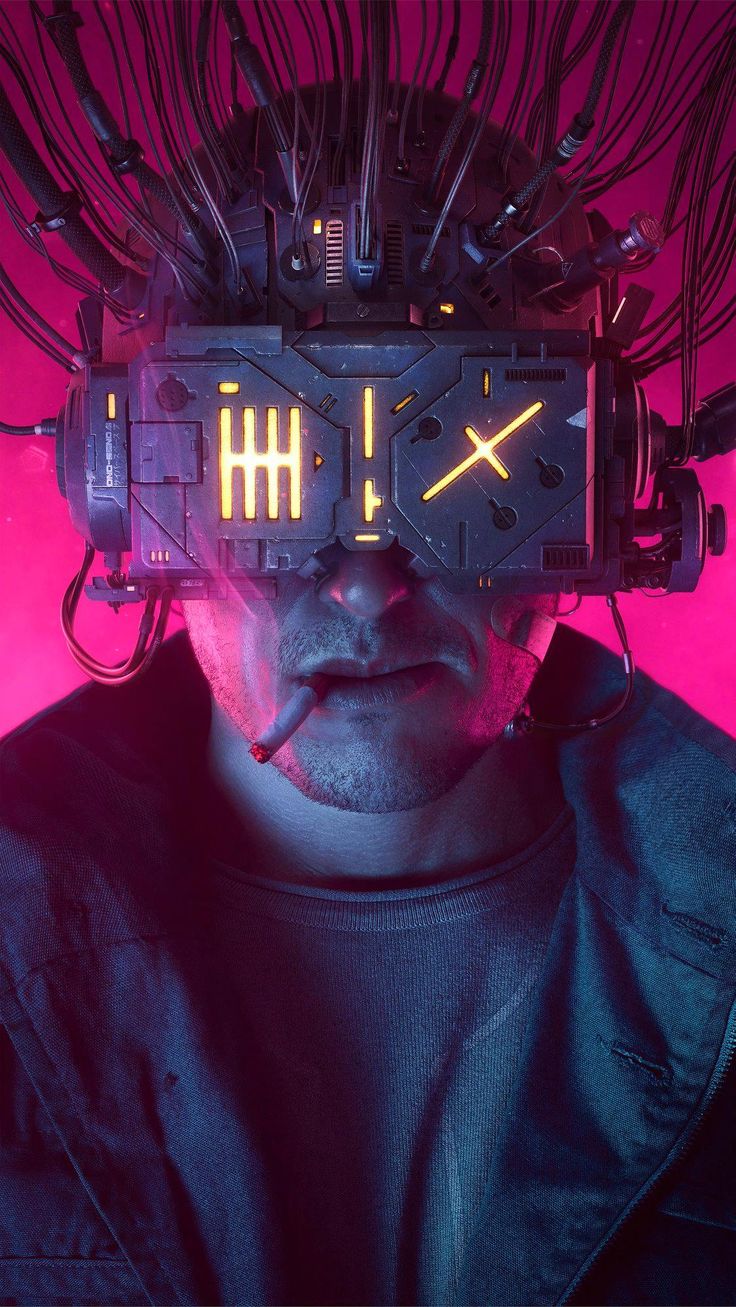

Ciò avviene in un momento critico in cui molte aziende di neurotecnologia stanno creando prodotti per leggere, interpretare e raccogliere dati neurali. Oltre agli impianti di chip come “Telepathy” di Neuralink , i dispositivi di consumo sono più facilmente disponibili che mai. La fascia Muse , ad esempio, è progettata per migliorare la pratica della meditazione utilizzando sensori EEG per leggere i modelli di attività cerebrale .

I dispositivi neurotech non invasivi non sono commercializzati come dispositivi medici, il che significa che non sono regolamentati e le aziende possono raccogliere e vendere i dati degli utenti. Questa nuova legge proteggerà tali dati da potenziali abusi.

Il senatore democratico della California Josh Becker ha affermato che l’importanza di proteggere i dati neurali nello Stato “non può essere sottovalutata”.

Il disegno di legge ha ricevuto ampio sostegno dall’American Academy of Neurology e da numerose altre organizzazioni che si occupano di regolamentazione medica e della privacy.

Alcuni esperti sostengono che gli emendamenti al disegno di legge non erano necessari, poiché i dati neurali erano già coperti dalla biometria e la modifica non fa che chiarire ulteriormente la questione.

Altri esperti ritengono che le aziende neurotecnologiche abbiano eccessivo accesso ai dati neurali.

Un rapporto della Neurorights Foundation pubblicato nell’aprile 2024 ha esaminato i documenti di policy di 30 aziende. Ha rivelato che la maggior parte delle aziende ha accesso illimitato ai dati neurali degli utenti . Oltre il 50% delle aziende nel rapporto ha condiviso questi dati con terze parti.

Secondo esperti come Rafael Yuste, presidente della Neurorights Foundation e neuroscienziato presso la Columbia University, non sono solo i dati raccolti a rappresentare un pericolo, ma anche le inferenze che si possono ricavare da questi dati.

Siamo già in grado di decodificare accuratamente i sentimenti e i pensieri degli utenti, e non è sufficiente per regolamentare i dati cerebrali , secondo Yuste. Il disegno di legge deve andare oltre e impedire alle aziende di neurotecnologia di fare previsioni basate sui pensieri degli utenti.

Marcello Ienca, professore di etica dell’intelligenza artificiale e delle neuroscienze presso l’Università tecnica di Monaco di Baviera, ha affermato che questa inferenza viola “estremamente” i diritti alla privacy, indipendentemente dal fatto che siano state utilizzate neurotecnologie, biosensori, riconoscimento facciale o altre tecnologie.

Secondo Ienca, la mossa più saggia sarebbe quella di regolamentare gli algoritmi che queste aziende utilizzano per fare previsioni, piuttosto che le aziende di neurotecnologia stesse e i dati cerebrali .

La California segue le orme del Colorado

La California non è il primo stato ad approvare questo tipo di legge.

Ad aprile, il Colorado è diventato il primo stato degli Stati Uniti a modificare la propria legge sulla privacy per includere i dati neurali. Anche il Minnesota sta valutando una proposta di legge autonoma per proteggere i dati cerebrali. Ma sono sufficienti le azioni intraprese dai singoli stati?

Molti credono che siano necessarie normative federali o globali per impedire alle aziende di raccogliere e vendere i nostri dati cerebrali . La Neurorights Foundation sta conducendo una campagna per un nuovo trattato internazionale sui neurodiritti, con un’agenzia internazionale per garantire che tutti lo rispettino.

Ciò sarà probabilmente difficile da realizzare, o quantomeno molto lontano. Nel frattempo, tutti i dispositivi neurotech potrebbero essere classificati come dispositivi medici, il che significa che richiederanno l’approvazione della FDA.

In alternativa, si potrebbero apportare modifiche alla legge federale degli Stati Uniti per riconoscere i dati cerebrali come “dati sanitari sensibili”, garantendone la protezione ai sensi dell’Health Insurance Portability and Accountability Act (HIPAA).